在数字浪潮席卷全球的今天,“数据”已不再是一个抽象的IT术语,而是驱动社会进步、企业创新和个人决策的核心资产。理解数据概念及其处理流程,是把握时代脉搏的关键。本文将系统性地探讨数字背景下的数据核心概念、数据处理的生命周期及其深远意义。

一、核心概念:数据、信息与知识

在深入讨论“数据处理”之前,首先需要厘清几个基础概念。

1. 数据(Data):是未经加工的原始事实或观察记录,是信息的载体。它可以是数字、文字、图像、声音等形式。在数字背景下,数据通常以二进制的形式存储于各类设备与系统中。数据本身缺乏上下文和目的,例如“25℃”、“用户A点击了按钮B”。

2. 信息(Information):是经过处理、被赋予上下文和意义的数据。数据处理的目的之一就是将数据转化为信息。例如,将“25℃”这个数据,结合“北京”、“2023年7月1日下午2点”等上下文,就形成了“北京在2023年7月1日下午2点的气温为25℃”这一条有价值的信息。

3. 知识(Knowledge):是通过分析、关联大量信息而形成的系统性理解、规律或洞见。例如,通过分析多年北京夏季气温信息,我们可以得出“北京七月平均气温较高”的知识,并据此指导生产生活决策。

从数据到信息再到知识,价值密度逐级升高,而数据处理正是实现这一价值跃升的核心引擎。

二、数据处理:定义与核心流程

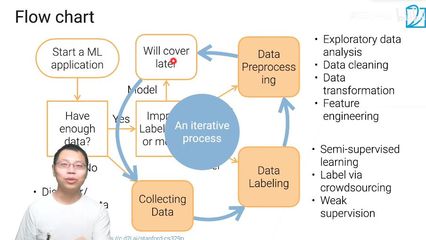

数据处理,是指对数据进行采集、整理、转换、分析等一系列操作,以提取有价值信息、形成知识并支持决策的过程。在数字背景下,这一过程高度依赖计算机和算法。一个完整的数据处理生命周期通常包含以下关键环节:

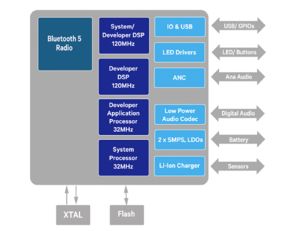

1. 数据采集:这是数据处理的起点。来源极其广泛,包括物联网传感器、业务系统日志、社交媒体、交易记录、公共数据集等。关键目标是确保数据的全面性、准确性和及时性。

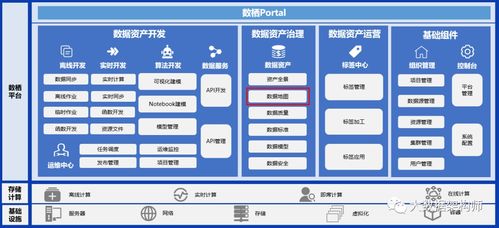

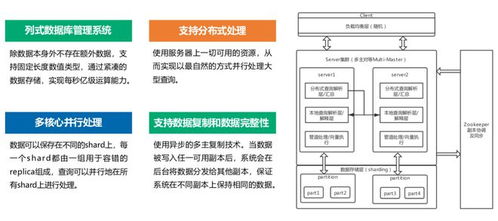

2. 数据存储与管理:海量数据需要安全、可靠、高效的存储方案。从传统的关系型数据库到分布式文件系统(如HDFS)、NoSQL数据库(如MongoDB)以及云存储服务,技术演进为处理海量、多样、高速的“大数据”提供了基础。数据管理则涉及数据组织、编目、质量控制和安全管理。

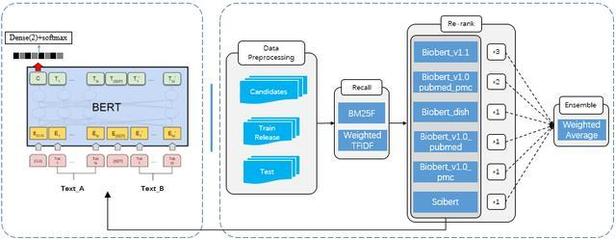

3. 数据清洗与整合:原始数据往往存在缺失、错误、重复、格式不一致等问题。数据清洗旨在识别并纠正这些“脏数据”,保证数据质量。数据整合则是将来自不同源头、不同格式的数据进行关联和合并,形成统一、一致的视图。

4. 数据转换与加工:根据分析目标,对数据进行计算、聚合、分组、特征工程等操作。例如,将销售流水按日汇总为日销售额,或从用户行为日志中提取“页面停留时长”、“点击频率”等特征。

5. 数据分析与挖掘:这是提取价值的核心阶段。通过统计分析、机器学习、数据挖掘等算法,从数据中发现模式、趋势、关联和异常。例如,进行销售预测、用户分群、风险识别或推荐系统构建。

6. 数据可视化与呈现:将分析结果以图表、仪表盘、报告等直观形式呈现,帮助决策者快速理解复杂信息,实现“数据驱动决策”。

7. 数据应用与行动:将数据分析的洞见转化为实际的业务行动、产品优化或战略调整,最终实现数据价值的闭环。

三、数字背景下数据处理的特点与挑战

当前的数据处理呈现出鲜明的时代特征:

- 规模巨大(Volume):数据量从TB级迈向PB甚至EB级。

- 种类繁多(Variety):结构化数据(如数据库表格)与非结构化数据(如文本、视频)并存。

- 速度极快(Velocity):数据产生和流动的速度前所未有,要求实时或近实时处理(如金融风控、智能交通)。

- 价值密度低(Value):海量数据中蕴含高价值的信息比例较低,需要高效的处理技术进行“沙里淘金”。

随之而来的挑战也异常严峻:数据安全与隐私保护(如GDPR、个人信息保护法)、数据孤岛的打破、处理技术与人才的短缺、以及从数据中获取可信、可解释洞见的难度等。

四、数据处理——数字时代的基石能力

总而言之,在数字背景下,数据是新的石油,而数据处理则是提炼石油、将其转化为强大动力的精炼厂。它连接着原始的比特字节与深刻的商业智慧、科学发现和社会洞察。无论是企业构建竞争优势,还是公共部门提升治理效能,抑或是科学研究取得突破,都离不开高效、智能的数据处理能力。深刻理解数据概念,掌握数据处理流程,并积极应对其挑战,是个人、组织乃至国家在数字化未来中致胜的关键。